1. はじめに

こんにちは。AIチームの栗原です。

2023年8月30日(水)〜2023年8月31日(木)(および8/29(火)ハッカソン)に浅草橋ヒューリックホールにて開催されたYANS2023で、弊社から2件のポスター発表を行いました。

NLP2023に続いて4年ぶりのオフライン開催となっており、会場はまさに大盛況でした。やはり、対面というのもあり議論が捗りまして、有意義な期間となったことは間違いないです。

本記事では、弊社からの発表の中で行われた質疑応答や議論の内容について掲載します。

発表内容や概要については、前回の記事を参照いただけると幸いです!

2. 各発表のポスターと議論

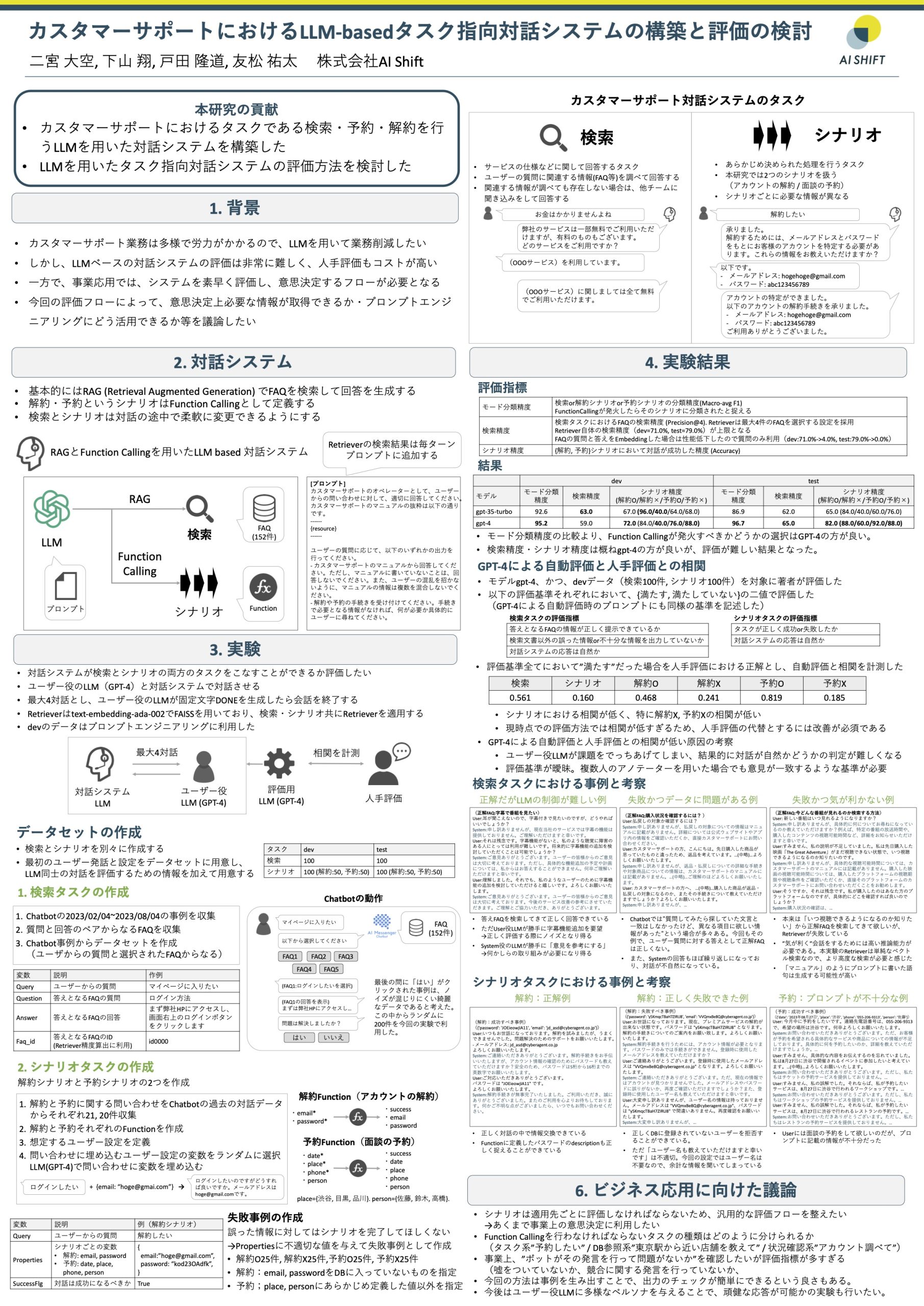

[S3-P08] カスタマーサポートにおけるLLM-basedタスク指向対話システムの構築と評価の検討

議論

Q: 自動評価と人手評価で相関係数が低い点について

A: 相関係数が低いということは評価用LLMが正しく評価できていないということを表します。この対策として現状以下の2つを考えています。

- 両者が一致しない場合の傾向分析をもとに評価用LLMのPromptを改善する

-

評価指標に関して、ragasなどを参考に改善する

また、評価指標をまとめて相関係数を算出していましたが、評価指標ごとに別々に相関係数を算出することでより詳細に傾向分析したいと思います。Q: LLMと記載してある部分はOpenAIを想定していますか?

A: 今回の実験では、対話システム・ユーザー役LLM・評価用LLMの全てにOpenAIを利用していますが、それに限りません。一般的にオープンなLLMの利用も考えておりまして、精度とコストの観点から最適なものを選びたいと思っています。

Q: シナリオタスクは予約と解約だけを想定していますか。

A: いいえ、あらゆるタスクを想定しています。シナリオタスクに限らず、カスタマーサポートのタスクは様々考えられ、Chatbotのドメインにより大きく異なります。そこで、本研究はどのドメインであっても共通して活用できる評価フレームワークを目指しました。これにより最小限のコストで対話システムの良し悪しを自動で評価でき、改善に繋げられる作業フローを構築する予定です。

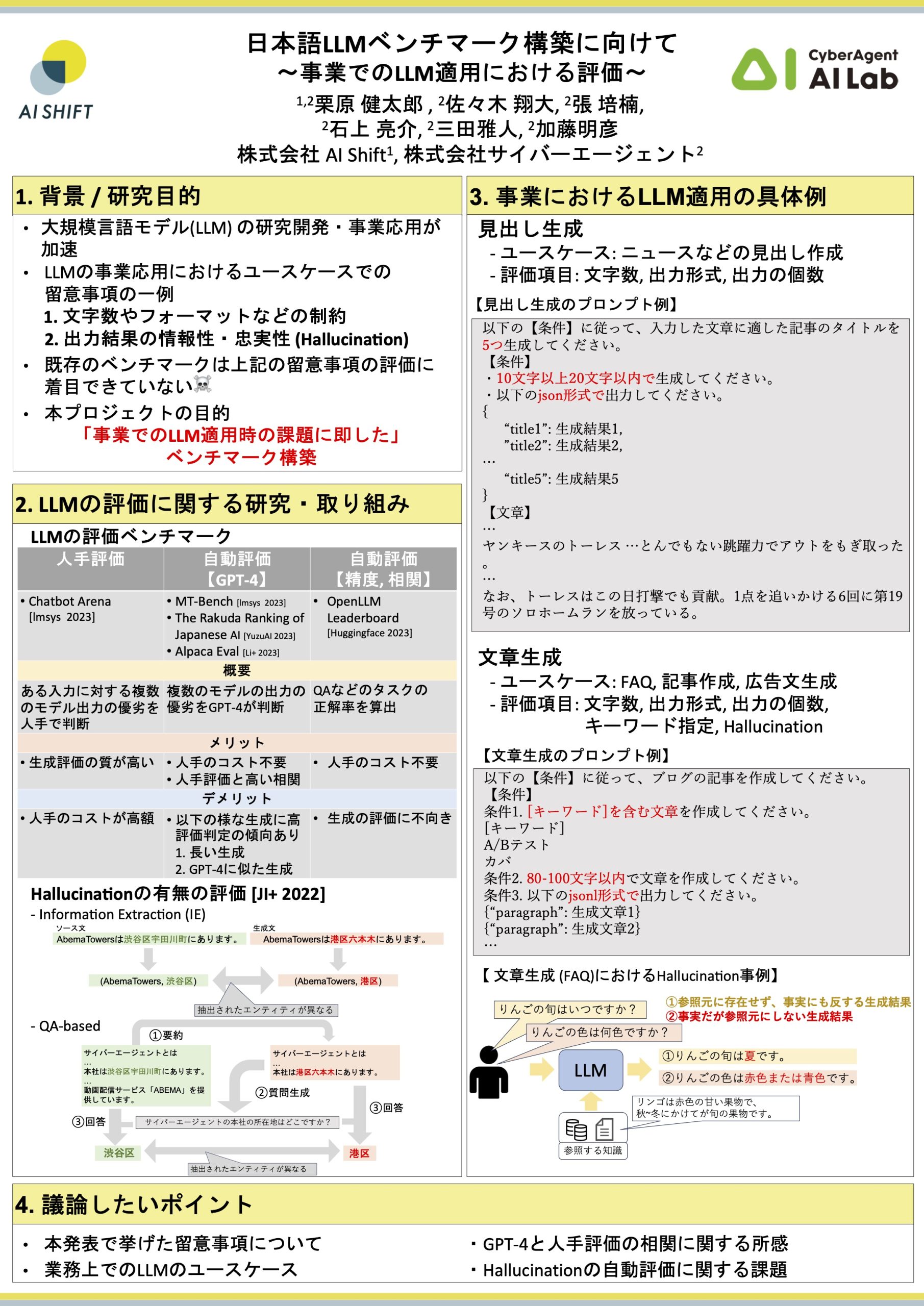

[S2-P01] 日本語LLMベンチマーク構築に向けて

議論

Q: 評価したい項目に挙げているものは全てFunction callingで解決できるのでは

A: 全ては解決できないと考えています。「JSONフォーマットでの出力」については制御できる一方、生成の個数や文字数、あるいはキーワードについては完全には制御できないと認識しております。

Q: 文字数の制御ってそもそも難しいのでは。

A: 現状使用可能なLLM大半において共通する難しいポイントであると考えています。一方で、ベンチマークの構築を考えた時、全てのタスクがLLMに容易に解けてしまうような内容では不十分、むしろ将来的に解けるようになっていてほしいが解けるかわからないタスクを用意するべきと思っています。ですので、今のLLMにとって難しいのはむしろベンチマーク構築の観点においては、好都合かもしれないです。

Q: Function callingで解決できるような項目についても評価する理由は。

A: Function callingはOpen-AI社が提供する範囲のサービスでしか適用することができないと認識しています。つまり、サイバーエージェントが提供するCALMをはじめとした開発・公開されている種々の国産LLMの評価を実施する上では、Function callingの事情には依存せず、評価項目として妥当性はあると考えています。

Q: 文字数の制約を満たすか、など決定論的に求めることが可能な項目については、仮に生成に不備があっても後続の処理でフィルタリング可能と考えている。その上で、今回提案する評価指標の改善を試みる意義は。

A: 金銭面、時間効率の面で想定する評価指標の性能向上を目指す意義があると考えている。金銭面においては、コストカットになると考えている。特にOpenAIのAPIサービスは生成のトークン長に応じたコストが発生する事情がある。時間効率の面について、フィルタリングされてしまうような無駄な推論が減ることで推論時間(あるいはLLMを組み込んだシステム全体の処理時間)の短縮にも寄与する可能性があります。

Q: ポスターの例とは逆に、キーワードを逆に含んでほしくないみたいなユースケースもあると思います。

A: こちらについては完全に同意で、間違いなくあると認識しています。例えばチャットボットにおいては、ボットに公序良俗に反するような生成結果は出力してほしくないなというようなことが考えられます。

3. その他の活動

ハッカソン

- 8/29(火)のハッカソンに栗原が参加しました。デモアプリハッカソンを通じて学びを得ることができました!特に優勝作品のデモアプリからは、生成AIが現状発揮できるパフォーマンスの範囲で価値のあるアウトプットを出すための試行錯誤の姿勢を学ぶことができました。

パネルディスカッション

- 8/31(木)のパネルディスカッションにて、弊社から友松が登壇しました!やはり、LLMに関するアジェンダが多く、LLMが取り巻くNLPの界隈に期待や不安を感じる多くの学生や社会人の声に答えていくディスカッションであったと感じました。私自身もハッとさせられる意見もあり刺激的なセッションでした!

4. 最後に

オフラインの会議はやはり得るものが本当に多かったように感じます。私事ですが自身の「日本語LLMベンチマーク構築に向けて」については奨励賞までいただくことができました。ありがとうございます。一研究者として改めて身が引き締まる思いです。

🏆受賞者一覧🏆#YANS2023 奨励賞の表彰を行いました!

おめでとうございます🎉 pic.twitter.com/ZPhaSIfuKG— NLP若手の会 (YANS) (@yans_official) August 31, 2023

最後に、今回このような素晴らしい交流・議論の場を準備してくださったYANS2023運営委員の皆様、本当にありがとうございました。次年度の開催を楽しみに、引き続き研究開発に取り組んでいきます!