こんにちは。

AI Shift AIチーム 兼 サイバーエージェントAILab 完全自動対話研究センターの邊土名(@yaelanya_ml)です。

この記事はAI Shift Advent Calendar 15日目の記事になります。

本稿では、先日12月13日(水)〜14日(木)にかけて開催されました 第14回対話システムシンポジウム(人工知能学会 言語・音声理解と対話処理研究会 第99回研究会)で発表した研究とシンポジウムの内容について紹介します。

対話システムシンポジウム

対話システムシンポジウムは、人工知能学会 言語・音声理解と対話処理研究会 (SIG-SLUD) が年に1回開催しているシンポジウムです。

今回は、昨年に引き続き現地&オンラインのハイブリッド形式で実施されました。

現地会場は、東京都立川市にある国立国語研究所で開催されました。

こちらも昨年から引き続きの開催場所になります。

現地会場の国立国語研究所

統計情報

シンポジウムのクロージングに発表された発表件数と参加者の統計情報です。

- 発表件数:42件

- 招待講演:1件

- 口頭発表:10件

- ポスターセッション:18件

- インダストリーセッション:9件

- 対話システムライブコンペティション:4件

- 国際会議報告:4件

- 参加登録者数:309名

- 現地参加者数:154名

- オンライン同時視聴者数:72名

去年の統計情報と比較しますと、発表件数はあまり変わらず、リモート参加者が減少、現地参加者が増加しているようです。

AI Shiftからの発表

AI Shiftからは1件の発表を行いました。

カスタマーサポートにおけるLLMを用いたRAGベース対話システムの評価と事業活用に向けた取り組み

発表概要

- 著者:二宮 大空(株式会社AI Shift)

- 日時:12月14日(木)13:40-15:20 インダストリーセッション

こちらの発表の詳細は、以下の記事をご覧ください。

【AI Shift Advent Calendar 2023】RAGの自動評価の活用|第14回対話システムシンポジウムで発表します | 株式会社AI Shift

質疑応答

Q. Knowledge DBを非エンジニアが作ることは難しくないですか?

A. 現状はKnowledge DBとして、単純なテキスト集合、もしくはQA集合を考えており、その場合であれば本稿のように非エンジニアが作ることが可能であると考えています。しかし、木構造を用いたIndexingやNodeといった概念を考慮すると対策が必要です。より高度な検索にも対応できるような仕組みと体制作りに取り組みたいと思います。

Q. 自動評価は上手く機能しますか?

A. ある程度上手く評価できていると感じますが、いくつかの事例ではLLMの評価に疑問を抱くこともありました。ただし、今回のアプリケーションにおける自動評価の目的は、RAGの正当な評価を得ることよりも、予期しない応答をしてしまう事例を収集してPromptとKnowledge DBの修正の方針を立てることに重きを置いています。そして、RAGの評価に関するツールは現在ragasをはじめとして複数提案されています。今後はそれらのツールを今回のアプリケーションの自動評価に活かしたいと考えています。

サイバーエージェントからの発表

AI Shiftではありませんが、せっかくの機会ですのでサイバーエージェントからの発表も簡単に紹介したいと思います。

サイバーエージェントからは2件の発表を行いました。

マルチモーダル入力からリアクティブな行動と応答発話の制御を両立する音声対話基盤の開発

発表概要

- 著者:馬場 惇、岡藤 勇希、大平 義輝、兵頭 亮哉、猪狩 大輔(サイバーエージェント)

- 日時:12月14日(木)13:40-15:20 インダストリーセッション

実空間での音声対話では,言語情報のやりとりだけでなく,ユーザやシステムの非言語の振る舞いを正確に対話に反映させることが重要である.しかし,人間同士の会話における非言語情報のやりとりは数十ミリ秒単位で高速に処理されており,単一の応答制御モデルで正確性と速度を両立することは難しい.また,対話タスクごとに必要な非言語情報は異なり,場面に応じてセンサーや認識モデル,出力デバイス等を切り替えられることが望ましい.そこで我々は,ROS2の分散処理構造の上で,各種マルチモーダル入力の認識器と対話応答制御,出力制御を分散的に並列実行できる音声対話基盤の開発を進めている.本セッションでは,簡易な対話デモを用意し参加者に体験いただくとともに,開発している基盤について説明する.

セールストークを対象としたエンゲージメント駆動タスク指向対話の検討

発表概要

- 著者:邊土名 朝飛、馬場 惇(サイバーエージェント)、赤間 怜奈(東北大学)

- 日時:12月14日(木)11:25-12:35 ポスターセッション2

こちらは私が現在 AILab 完全自動対話研究センターの方で取り組んでいる研究です。

本研究では、商品販売などの達成目標を持つ対話システムにおいて (1)対話継続意欲、(2)情報提供意欲、(3)目標受容意欲、の3種類のユーザの意欲(エンゲージメント)が対話目標の達成率向上の重要な要素と仮定し、これらのエンゲージメントを獲得しつつ目標達成を試みる対話を、エンゲージメント駆動タスク指向対話(Engagement-driven Task-Oriented Dialogue; ETOD)と定義する。本稿では、セールストークを対象としたETODコーパスの構築に向けた最初のステップとして、小規模な対話データ収集実験を実施し、大規模収集に向けた課題を調査した。実験では、数種類の商品の情報を掲載したWebページに訪れたユーザと、セールス対話システム間でテキストチャットを実施して対話データを収集、購買意欲やエンゲージメントのアノテーションを行った。

招待講演

慶應義塾大学理工学部の今井倫太先生から「大規模言語モデルの対話処理から始まるインタラクション研究元年」という題目で発表がありました。

講演では、主に大規模言語モデルが持つ対話文脈や意味把握能力を活用した「コンテキストライディング」技術について述べられていました。コンテキストライディング技術は、相互理解を促進するために文脈進展に関する支援を行うもので、具体的な研究として、逐次進展するインタラクションの文脈を大規模言語モデルで1文で表現・更新する情報文脈化手法について説明されていました。

個人的に面白かった話として、Theory of Mind Modelに関連した内容で「関係性がないと人は相手の言っていることが理解できない」がありました。人との関係性に着目した研究として、人間が指さした方向を予測し、ほぼ同時に見ることで共有感を出すロボットや、人間の五感を表現する発話を行うロボットに関する研究を紹介されており、大変興味深い内容でした。

対話システムライブコンペティション

対話システムライブコンペティションとは、オーディエンスの前で実際に対話システムを動作させ、そのパフォーマンスを評価する対話システムシンポジウムの恒例イベントです。ライブコンペティションは今年で6回目の開催となります。今回も前回同様、マルチモーダル対話システムが対象となりました。

- 公式サイト:対話システム ライブコンペティション6

今回のライブコンペティションで印象深かったこととして、「シチュエーショントラック」のみが実施されたことが挙げられます。これまでは、「オープントラック」と「シチュエーショントラック」の2つのトラックが設けられていました。オープントラックでは、任意のトピックでの雑談を行い、その会話能力を競うものでした。一方のシチュエーショントラックでは、特定のシチュエーションの中で状況に適した対話を行う能力が試されます。そして今年は「昨今の大規模言語モデルの進展に鑑み、任意のトピックで雑談をするオープントラックは一定の役割を果たした」との理由から、オープントラックは省かれ、シチュエーショントラックのみが実施されました。このアナウンスは対話システムの進歩を象徴すると思いますし、対話システムの研究に携わっている者として感慨深いものがありました。

もう一つ印象に残った点は、ライブコンペティションで発表した3チーム全てがChatGPT(GPT-3.5)もしくはGPT-4を利用している構成だったことです。そのため、発話の流暢さや内容の質については非常に高いレベルだったと感じました。しかしながら、レスポンスの遅さや、終話判定の誤りといった問題点も見受けられました。これらの問題は、ユーザー体験に直接影響を与えるため、今後の対話システムの研究では、よりリアルタイム性を重視する必要があると感じました。

今回1位を獲得したチームは、東北大学の「Hagi bot: LLMを用いた対話状態追跡と人間らしい振る舞いで自然な議論を行うマルチモーダル対話システム」でした。こちらのチームの特徴として、GPT-4でスロットフィリングをしていた点が挙げられます。また、リアルタイム生成に時間がかかる点を改善するためにGPT-4をStreaming modeで使用、応答文を文節ごとに分割し逐次発話させる処理など様々な工夫を施しており、大変勉強になりました。

国際会議報告

国際会議報告では、 SIGDIAL/INLG、ICMI、INTERSPEECH、EMNLPの計4件の発表が行われました。

SIGDIAL/INLGは、対話系の会議で有名なSpecial Interest Group on Discourse and Dialogue (SIGDIAL)と、言語生成系のInternational Natural Language Generation Conference(INLG)のjoint conferenceで、今年はチェコのプラハで開催されました。こちらはLINEヤフーの山崎 天さんから発表がありました。発表報告の中で意外だと思ったのは、SIGDIALの国別の投稿数は日本が2位、INLGでは3位と、かなり日本勢の勢いがあるという点でした。次回は京都開催とのことなので、気軽に参加することができそうです。論文紹介パートで触れられていたThe Timing Bottleneck: Why Timing and Overlap Are Mission-Critical for Conversational User Interfaces, Speech Recognition and Dialogue Systemsは個人的に気になる内容だったので後ほど読んでみようと思います。

2つ目の ACM International Conference on Multimodal Interaction (ICMI) は、マルチモーダルインタラクションに関する国際会議です。こちらはNAISTの田中 宏季さんから発表がありました。こちらの発表の際に離席していたため詳細は聞けていないのですが(申し訳ございません……)、次回はコスタリカ開催ということでした。

3つ目の INTERSPEECH は、International Speech Communication Association(ISCA)が主催する音声処理分野の最大規模の国際会議で、今年はアイルランドのダブリンで開催されました。こちらはNTTの北条 伸克さんから発表がありました。論文紹介のパートで挙げられていたCan ChatGPT Detect Intent? Evaluating Large Language Models for Spoken Language UnderstandingはSpoken Language Understanding (SLU)にLLMを適用した話で、AI Shiftの事業にも関係がある話なので非常に気になる内容でした。次回はギリシャ開催とのことです。

4つ目の学会はおなじみ(?)のEmpirical Methods in Natural Language Processing (EMNLP) です。今年はシンガポールで開催されました。こちらは名古屋大学の大橋 厚元さんから発表がありました。EMNLPというとNLPのイメージがかなり強いですが対話系の論文も投稿されています。対話系トラックで発表された main conference 採択論文のトピック分布を見ると、今年は「知識に基づく対話」が最多だったようです。ChatGPTやGPT-4の登場により発話の流暢さがかなり高まったため、より発話内容に焦点をあてた正確な情報提供力が注目されているのだと思います。また、実用指向のDialogue State Trackingの研究も多かったとのことでした。次回はアメリカ・フロリダ州のマイアミ開催とのことです。

おわりに

今回の対話システムシンポジウムは初の現地 & 発表参加でした。発表者として参加したことで、自分の研究を他の参加者に直接伝えることができ、質問やコメントを直接受け取ることができたのは大変貴重な経験でした。また、懇親会では、名刺を交換すると景品がもらえるという面白いゲームを運営委員の方が企画しており、初対面の人同士でも交流しやすくなる点でとても良い施策だと思いました。今回のシンポジウムでは、いつも以上に研究の議論や交流ができ、非常に有意義な時間を過ごすことができました。現地参加ならではのメリットを享受できたと感じています。

このような有意義で楽しい機会を提供してくださった運営委員の皆様、会場を提供してくださった国立国語研究所の皆様、そして参加者の皆様に心から感謝申し上げます。今後もこのような場で発表を続けられるよう、日々の研究開発に一層励んでまいりたいと思います。

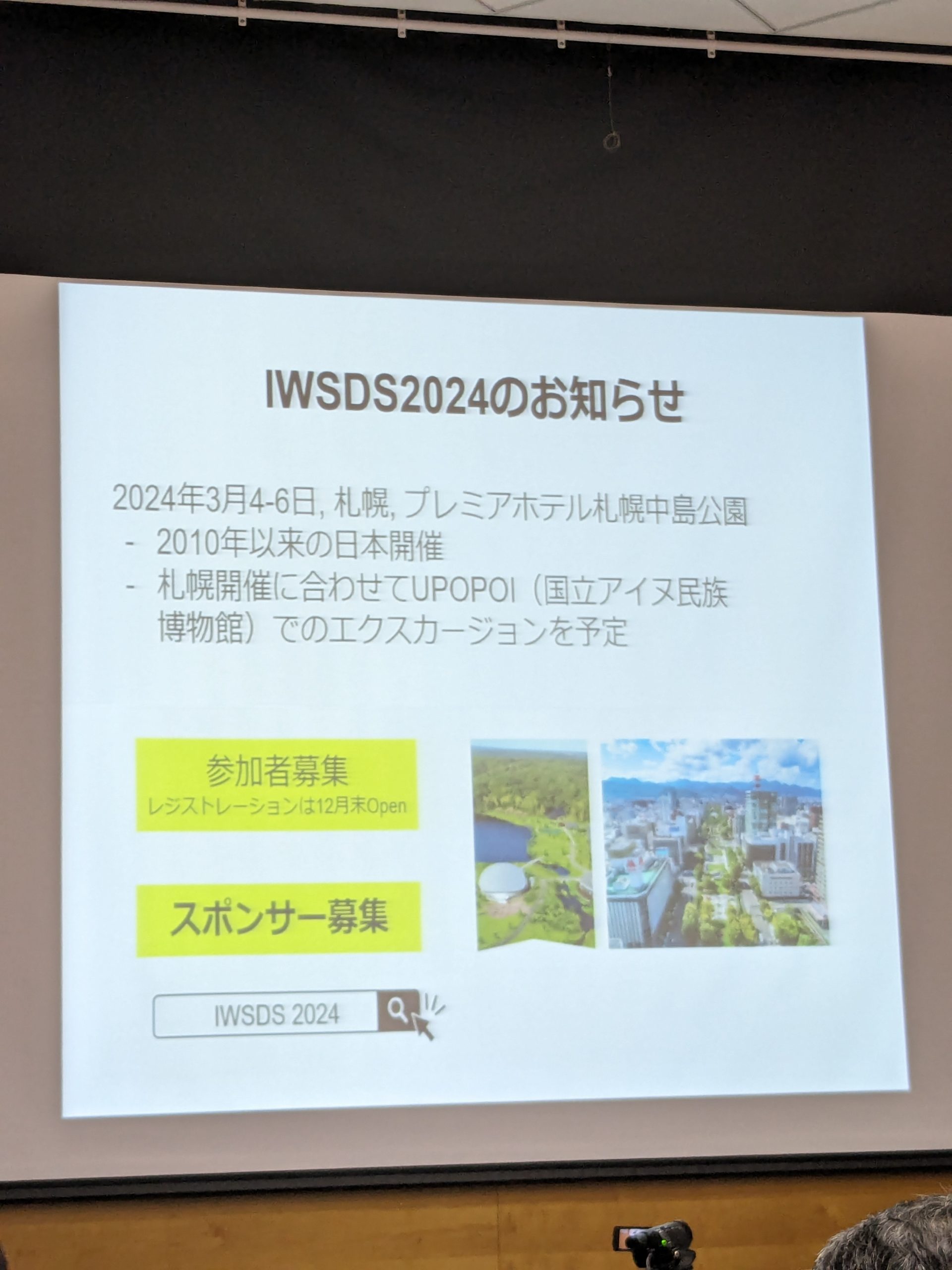

最後に、理研GRP 吉野先生から繰り返しアナウンスされていましたIWSDS2024の告知で締めたいと思います。

来年2024年3月4日〜5日に、音声対話システムに関する国際ワークショップ Workshop on Spoken Dialogue Systems Technology (IWSDS2024) が札幌で開催されます。参加者(聴講)とスポンサーを募集中とのことでしたので、ご興味のある方はぜひご検討ください。

来年のIWSDS2024は2010年以来の日本開催とのこと

AI Shiftではエンジニアの採用に力を入れています!

少しでも興味を持っていただけましたら、カジュアル面談でお話しませんか?(オンライン・19時以降の面談も可能です!)

【面談フォームはこちら】

明日のAdvent Calendar 16日目の記事は、開発チームの伴瞭太さんによる「React Hook Formで動的なFormを作るには」が公開される予定です。

こちらもよろしくお願いいたします。